El boom de la inteligencia artificial (IA) no ha pasado desapercibido para los legisladores del mundo. La Unión Europea (UE), al igual que otras organizaciones internacionales y países, está evaluando un nuevo marco legal para reforzar las regulaciones sobre el desarrollo y uso de esta herramienta. La legislación propuesta, conocida como ley de inteligencia artificial, se enfoca principalmente en fortalecer las reglas sobre la calidad de los datos, la transparencia, la supervisión humana y la responsabilidad sobre esta tecnología. Asimismo, aborda cuestiones éticas y desafíos de implementación en varios sectores, que van desde la atención médica y la educación, hasta las finanzas y la energía. Pero ¿cuáles son los riesgos de una IA desregulada y cuál es la verdadera necesidad de crear estas normas?

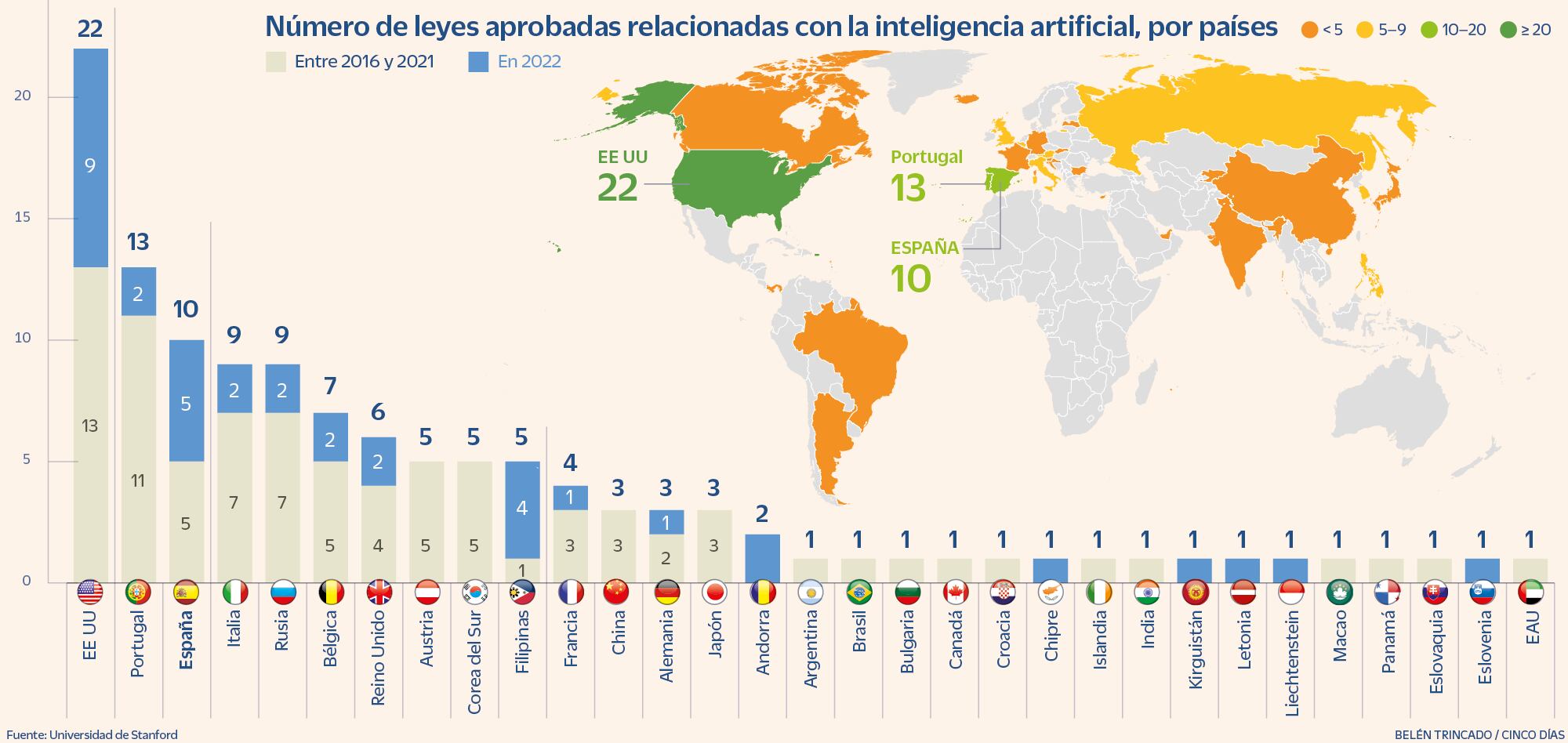

La tendencia hacia la legislación es innegable. El reporte del Índice de la inteligencia artificial 2023, elaborado por la Universidad de Stanford y publicado el 3 de abril, muestra que Occidente y algunos países asiáticos están creando cada vez más normas. El documento revela que, según los registros legislativos de 127 países analizados, 31 Estados ya han aprobado por lo menos una ley relacionada con esta tecnología. En total, se han decretado más de 125 normas a nivel global, y 37 de estas se aprobaron tan solo en 2022. Estados Unidos encabeza la lista del reporte, con 22 leyes aprobadas, seguido de Portugal y España, con 13 y 10 leyes, respectivamente. Empatan en el cuarto puesto Italia y Rusia, con 9 leyes cada una, y les sigue Bélgica, con 7, y Reino Unido, con 6 (ver gráfico).

Cabe destacar que el grado de regulación no es necesariamente proporcional a los avances en este campo en cada región. De hecho, Estados Unidos lidera ampliamente en términos de cantidad total de inversión privada en IA, con 47.400 millones de dólares en 2022, muy por encima de China, que se encuentra en segundo puesto con 13.400 millones de dólares y que solo ha ratificado tres leyes sobre IA desde 2016. El país norteamericano también encabeza la lista de número total de startups de IA, con casi el doble de empresas que la Unión Europea y el Reino Unido juntos, y 3,4 veces más que China, según la Universidad de Stanford.

La regulación europea entrará en vigor en 2024 y Bruselas asegura que su objetivo principal es abordar los riesgos generados por los distintos usos de la IA a través de “un conjunto de normas complementarias, proporcionadas y flexibles”. En esta línea, el Ejecutivo comunitario añade que estas reglas otorgarán a Europa un papel de liderazgo en el establecimiento de un nuevo “patrón oro mundial” en este terreno.

“Este marco brinda a los desarrolladores, implementadores y usuarios de la IA la claridad que necesitan, al intervenir solo en aquellos casos que las legislaciones nacionales y de la UE existentes no cubren. El marco propone un enfoque claro y fácil de entender, basado en cuatro niveles diferentes de riesgo: riesgo inaceptable, riesgo alto, riesgo limitado y riesgo mínimo”, señala un comunicado de Bruselas.

En este contexto, los principales factores que Europa y otros países buscan regular son los datos con los que trabajan las IA, la identidad y los datos de los usuarios que utilizan (por ejemplo en la vigilancia biométrica), la gestión de las preguntas y las respuestas que se plantean, así como su impacto ambiental y posibles sanciones a los usos negativos.

¿Por qué regular?

Todos especialistas consultados para este reportaje coinciden en que esta industria requiere una normativa. “Lo que caracteriza a este particular momento en el que nos encontramos, es que se parece al proceso de colonización del salvaje Oeste. Nos adentramos en un territorio sin ley e inexplorado, lleno de oportunidades pero del que desconocemos todos los riesgos”, responde Pablo Haya, director en el Instituto de Ingeniería del Conocimiento (IIC), al ser consultado sobre el tema.

Haya explica que se debe reflexionar de forma crítica sobre cómo se quiere que se desarrollen las IA que se alimentan de cantidades ingentes de datos. “La obtención y manipulación de estos datos puede tener implicaciones legales sobre los derechos de autoría, propiedad industrial, privacidad o protección de datos. Por ejemplo, con la regulación actual no es trivial responder a quién es el autor de una imagen generada por una IA”, observa.

Desde la Asociación de Auditoría y Control de Sistemas de Información (Isaca, por sus siglas en inglés), coinciden en que la regulación es “crítica” en este momento. Su embajador en España, Ramsés Gallego, indica que su impacto en la sociedad es innegable y que se debe regular y legislar acerca de los límites éticos del uso de tecnologías disruptivas como la algoritmia, la inteligencia artificial y el aprendizaje de máquinas generativo.

“De la misma manera que regulamos el acceso a las armas u otros aspectos sociales, algunas dimensiones tecnológicas merecen una conversación profunda, un debate social sereno y una regulación que proteja los intereses de los ciudadanos y de la sociedad en general, y eso incluye, por supuesto, al ecosistema empresarial”, apunta Gallego.

Un avance galopante

Un análisis del gigante tecnológico Intel refleja el acelerado (y preocupante para algunos) avance de la inteligencia artificial. Según la empresa, el entrenamiento de la IA creció más de cien millones de veces más rápido que la ley de Moore, el conocido postulado que afirma que la velocidad de los ordenadores se duplica cada dos años.

En este contexto, un grupo de más de 10.000 expertos firmó recientemente una carta abierta en la que se apelaba a todos los laboratorios de IA para que “pausen inmediatamente durante al menos seis meses el entrenamiento de los sistemas de IA más potentes que GPT-4″. El comunicado, firmado por personalidades tan relevantes como Elon Musk, Steve Wozniak o Yuval Noah Harari, asegura que la IA representa un “cambio profundo en la historia de la vida en la Tierra”, y debe planificarse y gestionarse con el cuidado y los recursos correspondientes.

“Desafortunadamente, este nivel de planificación y gestión no está ocurriendo, a pesar de que en los últimos meses los laboratorios de IA han entrado en una carrera fuera de control para desarrollar e implementar mentes digitales cada vez más poderosas que nadie, ni siquiera sus creadores, pueden entender, predecir o controlar de forma fiable”, sentencia el documento.

Asimismo, Italia se ha convertido este mes en el primer país de Occidente en prohibir el conocido chatbot ChatGPT de OpenAI, aunque con motivos distintos. El regulador italiano de protección de datos ordenó a los creadores que dejaran de procesar “temporalmente” los datos de los usuarios del país, en el contexto de una investigación sobre una supuesta violación de las normas de privacidad de Europa.

El organismo italiano citó una violación de datos de OpenAI que permitía a los usuarios ver los títulos de las conversaciones que otros usuarios tenían con el chatbot. “Parece que no hay una base legal que sustente la recopilación y el procesamiento masivos de datos personales para ‘entrenar’ a los algoritmos en los que se basa la plataforma”, sostuvieron en el comunicado.

En esta línea, es conveniente mencionar que, según la investigación de la Universidad de Stanford, actualmente el procesamiento de datos no es el principal foco de las empresas de IA (por lo menos en términos de inversión). En 2022, el área de enfoque de esta tecnología con la mayor inversión fue la médica y de atención médica, con 6.100 millones de dólares, seguida por el procesamiento y la nube de datos (con 5.900 millones de dólares) y las fintech (con unos 5.500 millones).

Leyes y competitividad

En el sector tecnológico privado también hay consenso sobre la necesidad de regular la IA. Pablo Méndez, gerente de cuentas de Altia, alega que el motivo de la regulación se debe entender desde la base de que la IA es un software llamado a ejecutar tareas que, hasta hace poco, las realizaban los humanos.

Méndez reconoce que la pérdida de empleos y el abaratamiento masivo de servicios están entre los riesgos que se tienen que regular. “Del mismo modo que las leyes regulan lo que los humanos podemos o no hacer y las decisiones que podemos o no tomar, resulta necesario hacer lo mismo en el caso de las máquinas”, dice el ejecutivo.

Por su parte, la CEO y cofundadora de Mioti Tech & Business School, Fabiola Pérez, opina que la regulación puede tener tanto beneficios como perjuicios para las empresas. Según la experta, puede mejorar la confianza del público y establecer un campo de juego homogéneo para todas las grandes empresas, sobre todo, las gigantes tecnológicas. No obstante, también puede aumentar los costes y limitar la capacidad de innovación.

En esta línea, asegura que una normativa global podría homogeneizar el terreno entre Europa, China y Estados Unidos, al establecer un marco común para todas las compañías en cuanto a la competitividad. “En Europa tenemos que mirar a ejemplos anteriores de regulación, como la ley de protección de datos, y plantearnos si nos ha retrasado en el uso de la inteligencia artificial y en sus beneficios para la ciudadanía. Creo que plantear entornos regulatorios distintos entre Europa, China y EE UU puede ponernos en una situación de desventaja respecto a la aplicación, creación de nuevo tejido empresarial especializado y de alta competitividad y fuga de talento”, afirma.

Vicente Llamas, especialista en almacenamiento de datos de Dell Technologies, cree que es algo normal para las empresas adaptarse a la regulación de cada país o región, y que una regulación de la IA no debería suponer desventaja para ninguna, sino precisamente igualdad y ecuanimidad. “Quizá sea al contrario, y esto pueda suponer ventajas para las compañías que entienden y cumplen la regulación de cada país o región antes o mejor que el resto y que, por tanto, sus usuarios disfruten de sus ventajas de forma más rápida y segura”, señala Llamas.

También añade que los riesgos que la fantasía y la ciencia ficción asocian a las IA tienen más que ver con unas capacidades aún “enormemente lejos” de las que actualmente son factibles, y que es recurrente que, ante determinados avances tecnológicos o sociales, los reguladores se preocupen de su impacto y necesiten entenderlo y regularlo, si es el caso, por lo que cada país o región es soberano de marcar un ritmo legal para ello.

Entre los expertos consultados no hay un consenso sobre si serían mejor distintas regulaciones a nivel regional o una gran regulación a nivel global para la IA. Si bien muchos coinciden en la idoneidad de una suerte de “declaración mundial de la inteligencia artificial”, muchos descartan que un pacto de este tipo sea probable, posible o efectivo. En este sentido, muchos coinciden en que una legislación en el contexto europeo protegerá la región.

Sigue toda la información de Cinco Días en Facebook, Twitter y Linkedin, o en nuestra newsletter Agenda de Cinco Días